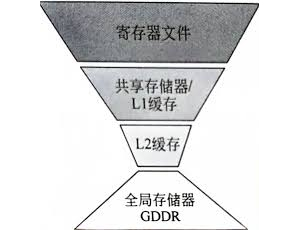

主持人: 大家好,欢迎收看今天的HPC技术专访。今天我们邀请到了1位HPC领域的专家,将为我们分享关于GPU存储层次的相关知识,并介绍如何优化GPU内存访问。 首先,我们请专家为我们介绍一下GPU存储层次的基本概念。 专家: 好的,GPU存储层次主要包括以下几个部分: * 寄存器:寄存器是GPU中最快的存储层次,位于GPU的核心中。寄存器的容量有限,通常只有几千个或者几万个。 * L1缓存:L1缓存位于GPU的核心中,容量通常为几十万个字节。L1缓存的速度比寄存器略慢,但比L2缓存快。 * L2缓存:L2缓存位于GPU的片上内存中,容量通常为几百万个字节。L2缓存的速度比L1缓存略慢,但比主存快。 * 主存:主存是GPU外部的存储,容量通常为几十GB或者几百GB。主存的速度最慢。 GPU存储层次的访问速度从快到慢依次是寄存器、L1缓存、L2缓存、主存。因此,在GPU程序中,我们应该尽量将数据存放在寄存器或L1缓存中,以提高性能。 主持人: 那我们知道了GPU存储层次的基本概念,那么如何优化GPU内存访问呢? 专家: 优化GPU内存访问的方法有很多,以下是一些常见的方法: * 使用寄存器:寄存器是GPU中最快的存储层次,因此尽量将经常访问的数据存放在寄存器中。例如,在矩阵乘法运算中,可以将矩阵A和矩阵B存放在寄存器中,以提高运算速度。 * 使用L1缓存:L1缓存的速度比寄存器略慢,但比L2缓存快。因此,如果数据的大小超过了寄存器的容量,可以将数据存放在L1缓存中。例如,在神经网络训练中,可以将权重和偏置存放在L1缓存中。 * 使用L2缓存:L2缓存的速度比L1缓存略慢,但比主存快。因此,如果数据的大小超过了L1缓存的容量,可以将数据存放在L2缓存中。例如,在图像处理中,可以将图像数据存放在L2缓存中。 * 使用局部性:局部性是指数据访问的趋势。如果数据访问具有局部性,那么我们可以将数据存放在相邻的存储单元中,以提高访问效率。例如,在矩阵乘法运算中,可以将矩阵A和矩阵B的元素存放在相邻的存储单元中,以提高运算速度。 主持人: 您刚才提到了局部性,那我们来举个例子,看看如何利用局部性来优化GPU内存访问。 专家: 好的,我们来看一个矩阵乘法运算的例子。矩阵乘法运算的计算公式如下: ``` C[i * n + j] = \sum_{k=0}^{n-1} A[i * n + k] * B[k * n + j] ``` 假设矩阵A和矩阵B的维度都是1024 * 1024。如果我们将矩阵A和矩阵B的元素存放在主存中,那么每次计算C[i * n + j]元素时,都需要从主存中读取1024个元素。 如果我们利用局部性,将矩阵A和矩阵B的元素存放在L1缓存中,那么每次计算C[i * n + j]元素时,只需要从L1缓存中读取10个元素。这样可以提高计算效率10倍。 主持人: 好的,非常感谢专家。 |

说点什么...